2023-02-22

THINKFORBL 사보 기술 파트 19호

모르면 우리가 알려주마! ‘알쓸신잡’ 씽크 백과사전

Thinkforbl

KNOWLEDGE

모르면 우리가 알려주마!

‘알쓸신잡’ 씽크 백과사전

인공지능(AI) 편향을 줄이기 위한 기술은 이미 세상에 존재한다. 리인(Re:In)도 그중 하나다. 따라서 편향을 줄이는 기술에 어떤 것이 있는지 알아볼 필요가 있다. 리인을 제외한 편향을 줄이기 위한 기술에 대해 살펴보자.

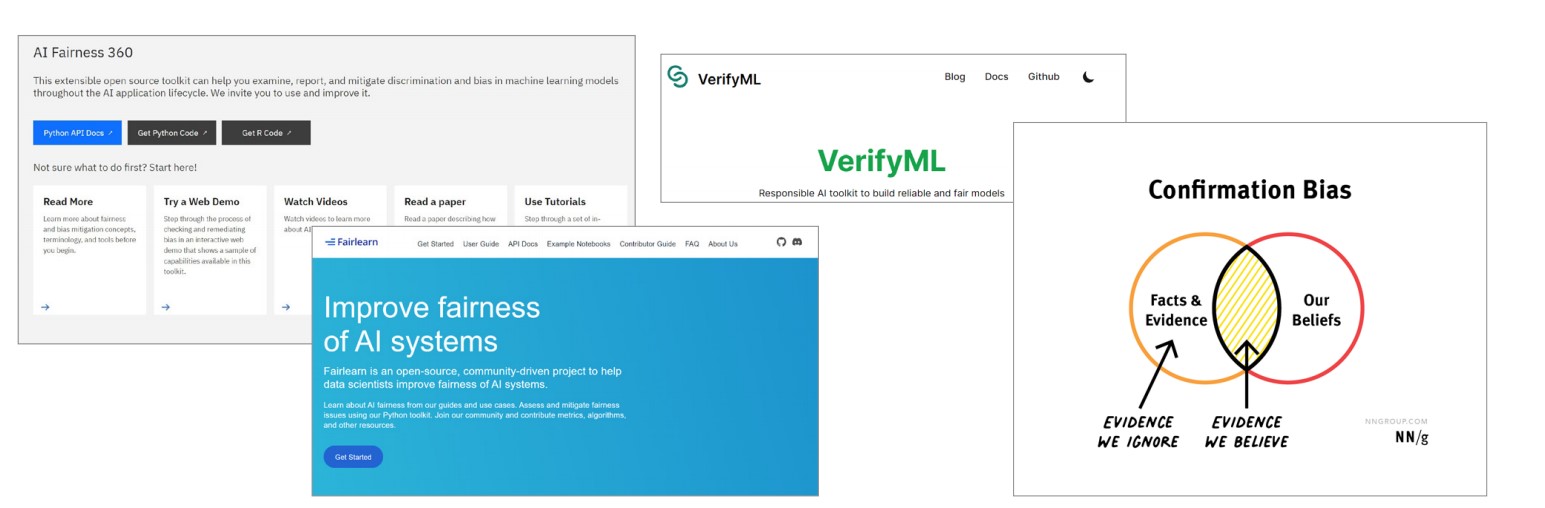

‘먼저 소개할 기술은 IBM의 페어니스 360(Fairness 360)이다. AIF360은 머신러닝 모델에서 편견을 감지하고 제거할 수 있는 오픈소프트웨어 툴킷이다. 해당 툴킷은 편향완화 알고리즘 및 편향 메트릭 설명, 산업적 유용성을 통합한 최초의 시스템이다. 개발자는 기계학습 파이프라인에 들어오는 원치 않는 편견을 정기적으로 확인하고 발견된 편견을 완화하기 위해 최신 알고리즘을 적용할 수 있다. 데이터세트와 모델의 편향성을 시험할 지표, 이러한 지표에 대한 설명, 데이터 세트와 모델 편향을 완화하는 알고리즘, 그리고 강좌 및 여타 연구 자료를 제공한다. AI360의 측정기준은 8가지이다. 대표적으로는 통계, 기회균등, 평균 승산, 이질적인 영향, 테일지수 등이 있다.

다음으로 소개할 툴킷은 구글 ML Fairness gym이다. 기계학습 기반 의사 결정 시스템의 시뮬레이션을 구축하고 장기적으로 공정성에 대한 이해를 높일 수 있다. 해당 시스템은 순차적 의사결정이 이뤄지면서 나타나는 결과를 기록‧평가해 이를 통해 데이터세트의 불완전성이나 내재한 편견을 반영한다. Fairness gym을 적용한 사례는 세 가지 정도다. 첫째, 대출 문제로 지원자 정보를 기반으로 갚을 확률을 예측하고 돈을 빌려줄지 말지를 결정한다. 둘째, 위험을 발견해야 하는 상황에서 검사나 감시 등에 대해 한정된 자원이 있을 때 자원을 어떻게 배분해야 할지 결정한다. 셋째, 대학 지원자 점수를 보고 합격과 불합격을 가린다.

세 번째 소개할 편향완화 도구는 MS Fairlearn이다. 공정성 평가 및 완화가 목적이다. 기계학습 시스템 개발자가 시스템 기능을 평가하고 비 공평하게 완화할 수 있는 오픈소스 Python 패키지이다. 파이썬으로 작성된 오픈소스로 깃허브에 공개되어 있을 뿐만 아니라 로컬이나 클라우드 환경에 직접 설치해 사용할 수 있다. 구성요소는 두 가지. 평가 대시보드와 완화 알고리즘이다. 평가 대시보드는 모델의 예측이 다른 그룹에 어떤 영향을 주는지 평가하기 위한 위젯이며 공정성 및 성능 메트릭을 사용하여 여러 모델을 비교할 수 있다. 완화 알고리즘인데 이진 분류 및 회귀의 불공정을 완화하는 알고리즘 세트다. 데이터 과학자나 비즈니스 리더가 공정성과 성능 사이에서 적절히 타협하고 요구사항에 가장 적합한 완화 전략을 선택할 수 있도록 도와준다.

마지막으로 소개할 편향완화 도구는 VerifyML이다. 해당 기술은 모델 카드를 정보소스로 사용하면 모델 세부 정보, 고려사항, 매개 변수, 성능 설명 가능성 및 공정성 결과를 쉽게 표현해준다. 기본적으로 5개 데이터 과학 모델을 제시하고 20개의 신뢰성 요구사항을 제공한다. 모델테스트는 부분군 불일치 테스트, 최소‧최대 메트릭 임계값 테스트, 작은 변화 테스트, 형상 중요도 테스트, 데이터 이동 테스트 등인데, 다른 방법도 가능하다.

글 / 김도현

2023-02-22

THINKFORBL 사보 기술 파트 19호

모르면 우리가 알려주마! ‘알쓸신잡’ 씽크 백과사전

Thinkforbl